[패스트캠퍼스 수강 후기] R 인강 100% 환급 챌린지 33차 미션

[패스트캠퍼스 수강 후기] R 인강 100% 환급 챌린지 33차 미션

패스트캠퍼스의 강의 중, 프로젝트와 함께 배우는 R 데이터 분석 올인원 패키지 Online를 수강하고 있습니다.

내용을 복습도 할 겸, 미션에도 참가할 겸, 블로그에 매일 매일 정리해 보게 되었습니다.

오늘은 33회차 미션!

Part 2) [R로 하는 데이터 분석] 데이터 분석 기본기 익히기

-

12. Ch 03. Logistic Regression - 02. R code로 구현하는 Logistic Regression

-

13. Ch 03. Logistic Regression - 03. Logistic Regression 결과의 해석

-

12. Ch 03. Logistic Regression - 02. R code로 구현하는 Logistic Regression

-

여기서도 caret 패키지를 사용

-

여러가지 로지스틱 회귀분석 방법이 있는데, 여기서는 boosted logistic 회귀분석을 사용할 것

-

로지스틱 회귀분석

-

Boosted Logistic Regression (LogitBoost)

-

약+약+약+...를 이용하여 약한 로지스틱 회귀분석들을 합쳐서 강화(부스팅)한다는 의미

-

뒤에서도 소개하겠지만, 각각 서로 다른 변수에 대한 회귀분석을 더해서 확률을 높인다는 개념

-

Logistric Model Trees (LMT)

-

로지스틱 회귀를 의사결정나무와 합친 모형

-

Penalized Logistic Regression (plr)

-

이건 페널티를 주는 형태로 정확도를 높이는 방법

-

Regularized Logistic Regression

-

Boosted Logistic Regression

-

약한 분류기들을 더하는 방법

-

약한 분류기 = 피처 하나로 만든 로지스틱 회귀분석 모델

-

심장병 분류 모델

-

나이..하나로 분류기를 만들고, 성별로도 만들고,콜레스테롤 수치로도 만들고

-

이를 쭉 더해서 모형을 개선

-

Logistic Model Trees

-

Logostic 회귀와 의사결정 나무를 합친 모형

-

성별과 나이 분포에서,

-

성별을 가지고 영역을 나누고

-

각각의 나누어진 영역을 다시 나누고

-

이런 식으로 계속 영역을 나누는 방법

-

Penelized Logistic Regression

-

페널티를 준다는 의미

-

부정적인 의미는 아님 ^^

-

beta의 영역에 제한을 준다는 의미

-

선형회귀에서는 y에 제한이 없고, 로지스틱 회귀에서는 y에 제한이 있는데,

-

여기서는 beta에 제한을 주는 것

-

왜 beta에 제한을 줄까?

-

모델의 복잡성을 조절하기 위해서

-

beta에 제한이 없을 때, 모형이 매우 복잡해질 수 있다.

-

오버피팅이 발생할 수 있다는 의미!

-

따라서 beta에 제한을 주면 오버피팅을 피할 수 있음

-

'plr'을 쓰면 L2정규화를 사용하여 beta가 정해짐

-

L2정규화 beta의 제곱에 대한 식을 아래와 같이 사용

-

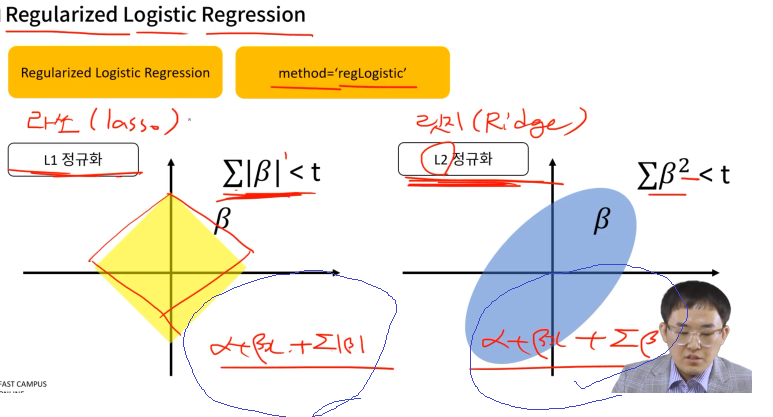

Regularized Logistic Regression

-

L1정규화

-

제곱이 아니라, 절대값을 사용

-

라쏘(lasso)라고 많이 부름

-

L2정규화는 릿지(Ridge)라고 부름

-

penalized는 릿지 리그레션, regularized는 라쏘 리그레션이라고 부르기도 함

-

결국 수식에선 아래와 같이 추가항이 붙는다고 함

-

13. Ch 03. Logistic Regression - 03. Logistic Regression 결과의 해석

-

먼저 Logistic Model Trees

-

반복도에 따른 정확도와 kappa 통계량을 확인 가능

-

21번째가 가장 정확

-

상태) 아마 21번 영역을 나누었을 때라는 의미일 듯

-

Penalized Logistic Regression

-

plr을 사용

-

여기에는 lambda가 나오는데...

-

이 의미?

-

lambda를 곱해서 beta의 영역을 조절할 수 있음

-

따라서 lambda의 크기에 따른 정확도를 확인할 수 있음

-

Regularized Logistic Regression

-

여기서도 accuracy, Kappa가 있고

-

cost, loss도 있고

-

L1, L2도 있고

-

dual, primal도 있고

-

primal은 파라미터 (beta) 기준 최적화

-

dual은 제약변수 기준 최적화

-

epsilon

-

학습을 하다가 언제 멈출지를 결정하는 변수

-

n회차와 n+1회차의 값을 비교해서 멈출 지 여부를 결정

cost

-

cost와 loss

-

loss를 아래와 같이 정의한다고 치자 (다양한 방법이 있지만 그 중 하나)

-

cost는 1/n을 곱했음

-

아래와 같이 표시

-

loss는 loss의 합

-

cost는 이를 n으로 나눈 것

-

다만 실무에서는 loss와 cost라는 용어가 많이 혼용됨

-

따라서 그때그때 용어가 어떤 의미로 사용되는 지 확인할 필요는 있음